LLM(大規模言語モデル)をWindowsのデスクトップから簡単に使えるようにしてくれるソフトがJanである。GPUを使う場合はNVIDIAのGPUが前提となっているが、ない場合にはCPUで動かすことができる。

Janを導入することでローカルPCでも快適にLLMが使えるようになるので紹介したい。

導入のきっかけ

Janを知ったのは、Copilotに次の質問をした時に教えてくれたのがきっかけだった。

llama2をチャットで動かす方法を教えて

Llama2をローカル環境で動かす方法を紹介しますね!Llama2はMetaが開発した言語モデルで、興味深い対話を生成することができます。以下は、Llama2をローカルで動かす手順です:

1Janのインストール:

JanはいろんなLLM(Large Language Model)を簡単に動かせるツールです。まず、GitHubからJanをダウンロードします。次に、JanでLlama 2 Chat 70B Q4をダウンロードします。

2Llama 2 Chat 70B Q4のダウンロード:

ダウンロードが完了したら、Janを起動して「Use」ボタンをクリックすれば、Llama2のチャットが開始できます。

3使ってみる:

早速質問をしてみましょう。自分のPCだと大体1トークン/秒くらいの速度で返答してくれるはずです。メモリ使用率に注意してください。

■Janのページ

https://jan.ai/about/

導入方法

ステップ1

Copirotが教えてくれた通り、まず下記のページからWindows版のインストールプログラムをダウンロードする。

プログラムを実行し、Janをインストールする。無事インストールできたらデスクトップにできたショートカット、またはWindowsメニューからJanを起動する。

ステップ2

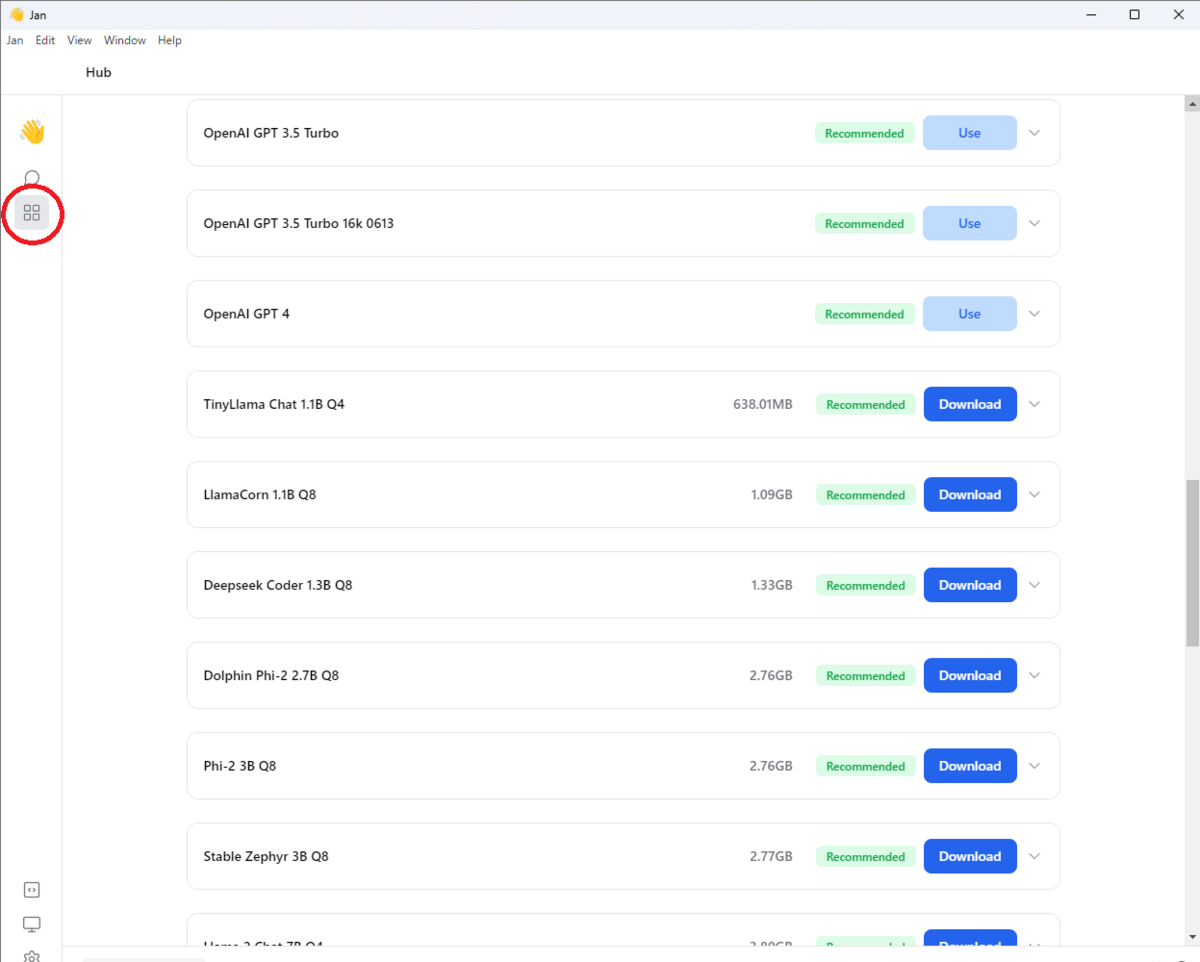

左メニューにあるHubアイコンを押すとモデルのダウンロード画面になるので、使いたいLLMを選びDownloadボタンを押す。

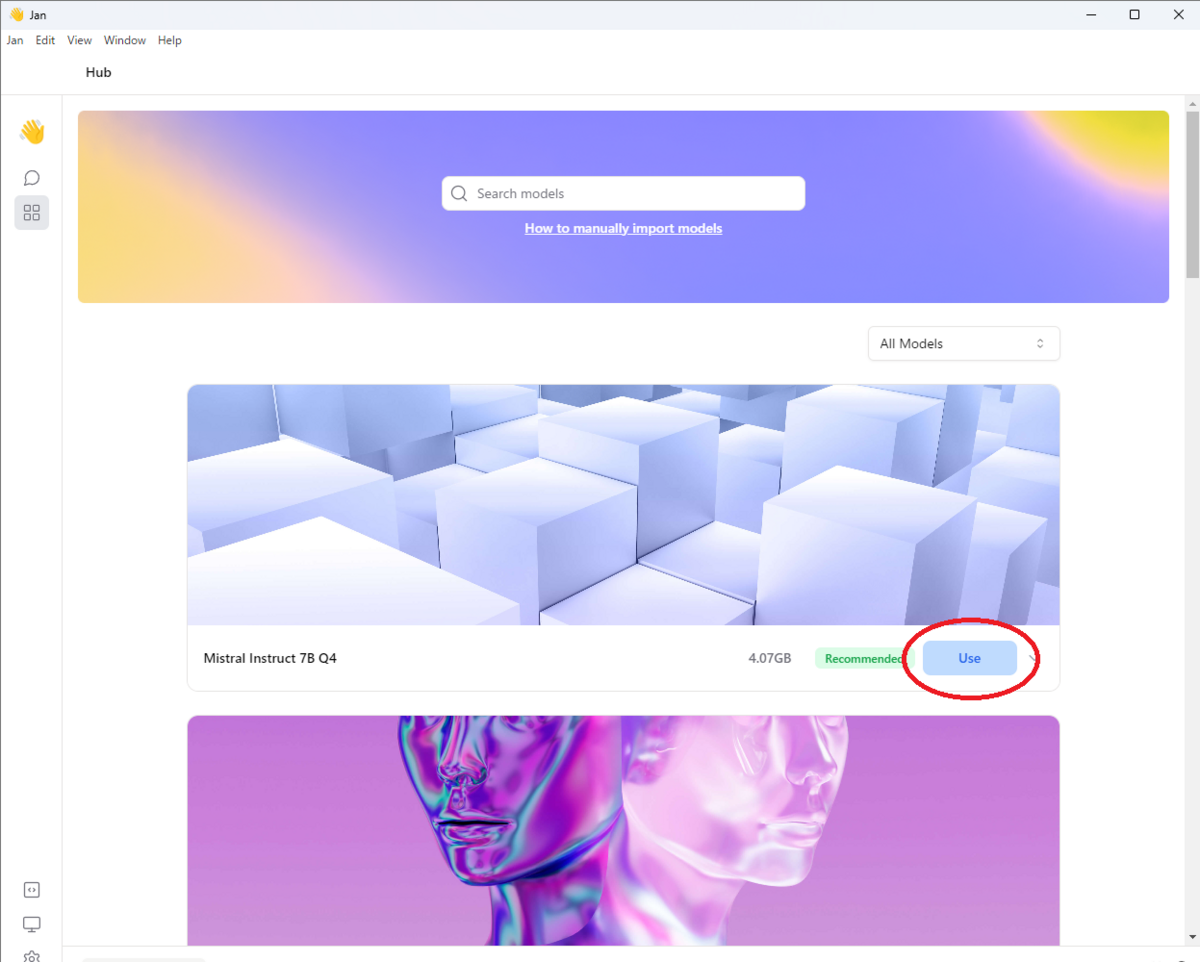

無事にダウンロードが完了するとUseボタンになるのでこれを押す。

もし、ダウンロードが全く始まらない現象が起きたら、アプリを起動し直したり、スレッドを閉じるなどの操作をしてみてほしい。私は何度か経験したが、操作している内に解決できた。まだ原因は不明である。

ステップ3

無事にダウンロードできていれば直ぐにチャットを始めることができる。

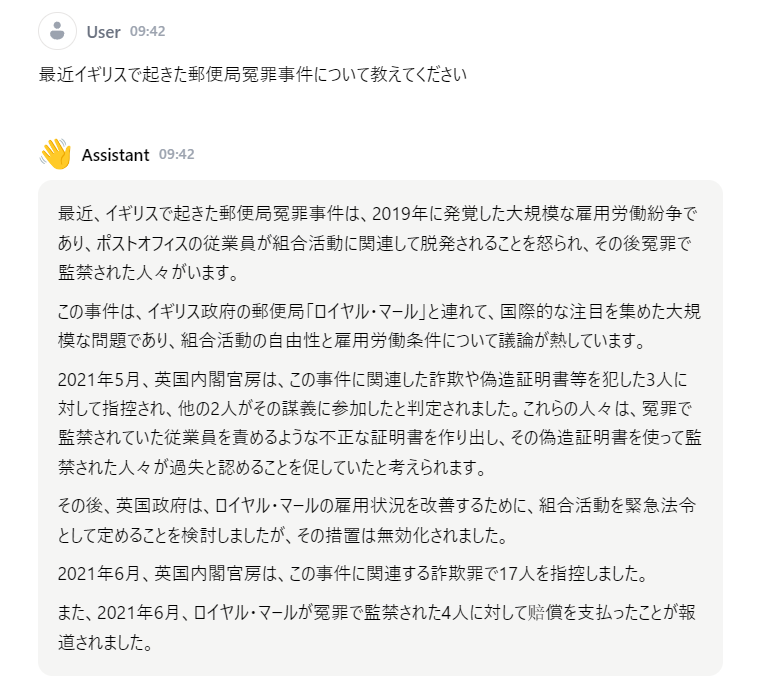

以下は「Trinity-v1.2 7B Q4」とチャットした例である。

古いデータを元に学習しているためだろう。期待した答えではなかった。最新の情報について聞く時は、GeminiやCopilotの方がよさそうだ。この子については日本語も少しあやしい気がする。

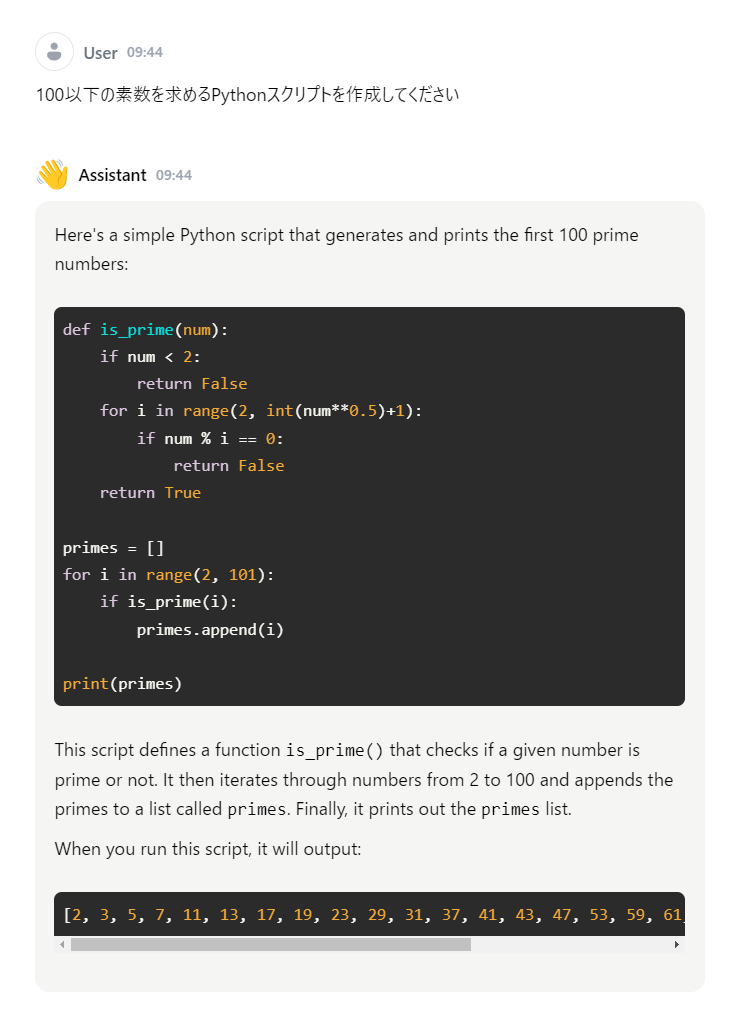

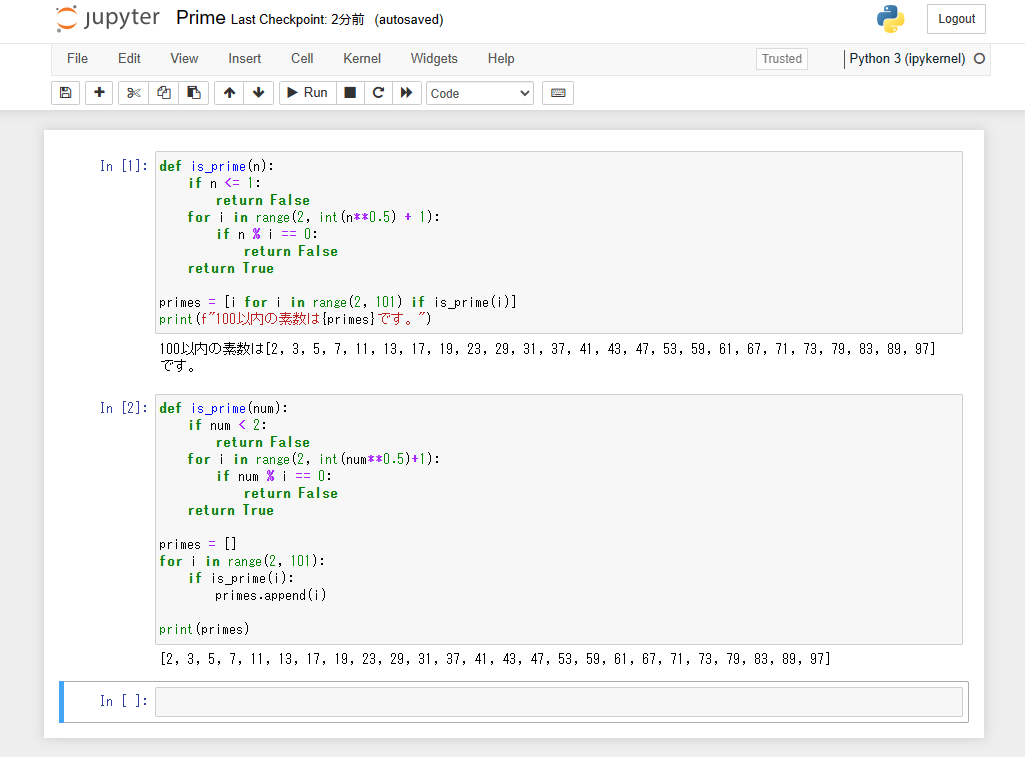

回答が英語で書かれているが、正しいスクリプトを返してくれた。先日導入したanacondのpython環境でテストした結果が以下である。

別のモデルでも試してみたが、このレベルのスクリプトなら正しく回答してくれるようだ。

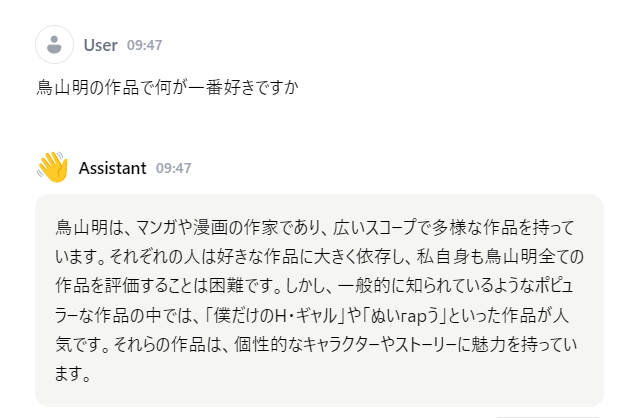

日本のサブカルチャーについてはほとんど学習していないようだ。鳥山明はこんな作品は描いてないだろう。亡くなられた鳥山さんに失礼だぞ!

まとめ

これまではLLMを動かすためには、Hugging Faceからモデルをダウンロードしたり、Pythonのサンプルプログラムを参考に動作環境を自分で用意するなど、導入のハードルは高めであった。Janを使うことでこれらのハードルがかなり下がると思う。

難しい質問をしても返答にかかる時間は10秒程度だろうか。私のPCではCPUでの処理だがストレスはほとんど感じないレベルである。

Janには標準で複数のモデルがダウンロードできるようになっている。また任意のモデルを追加することもできる。ELYZAの日本語学習済みモデルも追加できたので別の記事で紹介したい。